咖喱的功效与作用及副作用_手机AI助你点咖啡,App们准备好了吗?,不看后悔

来源:腾讯科技(ID:qqtech)作者:晓静 吴彬编辑:郑可君对手机厂商而言,AI技术的重要性日益凸显2024年,大多数手机厂商纷纷推出各类AI助手,实现了一键问屏(手机直接识别屏幕内容)、圈搜(圈出图片中的部分内容并精准搜索)、AI回邮件、AI写会议纪要、AI便签、AI日程管理等多功能应用。

其中,用AI助手点咖啡成为今年的一大亮点10月14日,原荣耀CEO赵明在直播中通过手机中的智能语音助手点了一杯美式咖啡,整个过程流畅自如,令人惊叹坐在一旁的周鸿祎直呼:“这太神奇了”同样在10月,vivo也推出了手机智能体“PhoneGPT”,演示的AI功能同样包括点咖啡。

在这些演示视频中,用户点咖啡只需两个步骤:第一步是通过手机系统自带的助手,通过语音或文字下达指令;第二步是付费下单(输入密码)中间的跳转App和下单过程,并不是AI直接在后台操作,而是AI模拟人类操作手机的全部过程,并在屏幕上显示出每个操作步骤。

11月,知名大模型公司智谱AI推出了AutoGLM,CEO张鹏现场演示了其发红包的功能,整个过程也仅需“下达指令”和“支付红包金额”两个步骤发红包和点咖啡一样,都应用了“大模型视觉理解”的能力,通过识别并操作手机屏幕上显示的内容来完成任务,仿佛模拟了人类用户的“点按”操作,而无需调用App的API。

这意味着,AI可以变成一个“虚拟数字用户”,人类用户能做的事情,它也能做这似乎带来了无限的想象空间,但也引发了我们的好奇:1. AI究竟是如何通过识别屏幕实现操作手机的?2. 如果在普通手机上安装一个第三方的大模型App,这台手机是否能瞬间变成AI手机?

3. 如果AI调用App不需要获得App的同意,移动互联网生态将发生怎样的变化?2024年,科技巨头竞相让AI“读懂”屏幕先来梳理一下现阶段用AI点咖啡和发红包的流程:1. 自然语言理解:用户通过语音或文字向手机助手发出指令;

2. 读懂手机界面:手机智能体通过识别手机界面,模拟人类进行点按操作;3. 跨应用协调执行:手机智能体能够在不同应用之间跳转,以完成复杂的多步骤任务张鹏在介绍Auto GLM时曾提到,“这项应用展示了大模型从对话(Chat)走向操作(Act),从生成式AI(GenAI)迈向代理式AI(Agentic AI)的演进趋势。

”这些操作背后,具体应用了哪些关键技术?2023年12月,智谱AI发表了一篇论文《CogAgent:GUI 代理的可视化语言模型》,提出了一个180亿参数的视觉语言模型——CogAgent,旨在解决如何让大型视觉语言模型(VLM)更好地理解和导航图形用户界面(GUI),从而提高自动化水平。

可以说,Auto GLM是基于这项研究的产品化体现,使手机、PC等端侧设备通过视觉语言模型,读懂手机界面,实现多步骤的连续和跨App操作2024年2月,阿里巴巴也发布了一篇关于Mobile-Agent的论文,主要解决如何在移动设备上实现自主的多模态代理,能够通过视觉感知和语义理解完成复杂的操作任务,并自主完成多步任务,且可以跨越多个App。

国外科技巨头也发布了类似的研究成果2024年4月,苹果发表了一篇论文《Ferret-UI: 基于多模态LLMs的移动UI理解模型》,介绍了Ferret UI模型Ferret UI建立在2023年10月发布的Ferret模型基础上,该模型仅有7B和13B两个大小,是一个多模态模型,专长于识别图像具体区域和定位点,这项能力甚至超过了当时最强大的多模态大模型GPT-4V。

苹果AI/ML研究科学家Zhe Gan在X上发布了一条推文,称Ferret可以“在一个图像中的任何地方、任何粒度上引用和定位任何事物”,并可以使用图像中任何形状的区域实现这一点通俗来讲,这意味着Ferret模型能够识别图像中指定区域的元素,并将其精确框选。

例如,如果用户在图像中圈出一个物体并询问其种类,Ferret不仅能够识别出该物种,还能理解用户所指的特定动物或植物这让人联想到今年各大手机厂商纷纷推出的“圈搜”功能用户可以通过圈选屏幕上的内容,快速获取相关信息,支持跨应用服务,方便用户直接跳转到所需的应用或功能,如荣耀手机支持“一圈即搜”功能的YOYO智能体;vivo提供的“小V圈搜”功能;OPPO的“小布助手”也具备相似的圈选功能。

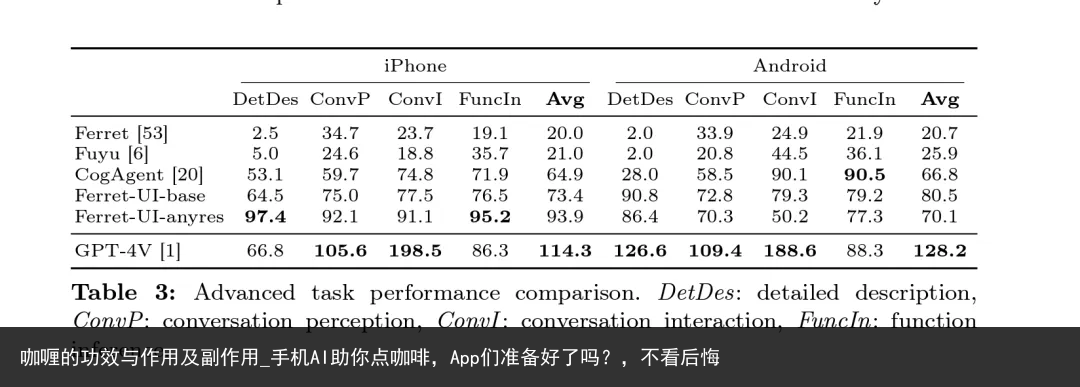

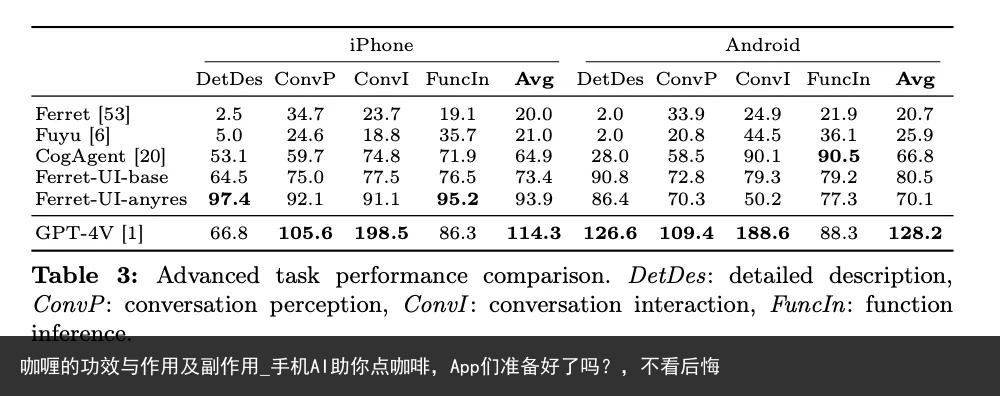

Ferret UI模型将Ferret模型的能力应用在手机、PC等端侧交互界面,用户用自然语言下达命令,模型能够直接“读懂”屏幕上的内容,包括App图标、屏幕上的文字Benchmark测试表明,在iPhone环境下,Ferret UI在初级UI任务中超越了GPT4-V,在包含高级任务的全任务平均得分非常相近,在安卓环境下表现略差。

2024年10月,苹果又发布了新的Ferret-UI 2模型,这次的升级主要集中在跨平台的用户界面(UI)理解上实验结果表明,无论是在iPhone、Android、iPad、Webpage还是AppleTV上,Ferret-UI 2都能有效地理解和响应用户意图,处理高分辨率的UI截图,并在多样化的设备生态系统中无缝扩展。

苹果在操作系统上的最大对手谷歌,更早在2023年2月24日发布了一篇论文,提出了Spotlight——一种基于视觉语言的移动端UI理解方法这是一个纯视觉的移动UI理解模型,不依赖于视图层次结构数据,而是直接从原始像素中理解UI屏幕。

采用了焦点区域抽取器(Focus Region Extractor)和区域总结器(Region Summarizer),使模型能够聚焦于屏幕上的特定区域,并生成基于ViT编码的屏幕区域的潜在表征3月19日,谷歌又发布了一个新的模型Screen AI,模型的大小还不到5B。

它能够识别和理解UI元素和信息图表的内容,包括它们的类型、位置和相互之间的关系,并能生成与屏幕UI元素相关的文本,如问题回答、UI导航指令和内容摘要Spotlight+Screen AI拼出了谷歌在端侧AI上的技术路线。

想要游戏更轻松、更高效吗?试试【星界云手机】吧!云端托管手游,搭配挂机脚本,让你无需手动操作,轻松完成日常任务,释放你的双手,尽情享受游戏的快乐!

Screen AI用来理解屏幕上的按钮和文字,而Spotlight则专注于屏幕上特定区域的细节,即使只给它看一小部分屏幕截图,也能告诉你那部分是干什么用的2023年10月,谷歌在自己的Pixel 8系列手机上也推出了circle to search功能。

同时,作为深度绑定的合作伙伴,“圈搜”功能也成为了三星手机AI功能的主打宣传点从荣耀、Vivo、智谱AI、阿里,到苹果和谷歌,端侧AI在现阶段的实现路径上似乎达成了一个共识:基于视觉理解大模型的技术基础,让手机直接“看懂”屏幕上的内容,并做出后续的类似于手机智能体的动作。

AI手机,不仅仅是安装大模型App那么简单听起来,在手机上实现AI功能并不复杂那么实操过程中,用户体验如何?腾讯科技深度体验了多个手机“智能体”产品,如点咖啡或圈搜等功能,基本都是采取上述技术方案,通过视觉理解大模型的支持,实现多步骤的操作。

现阶段,这些智能体大多反应速度慢,连续执行的过程中常需人类接管,有时甚至需要重复下指令才能完成任务对于新手用户而言,体验确实不太友好显然,这无法驱动用户为“AI手机”概念买单此外,即使没有内置AI功能的手机,安装大模型App后也能实现相关功能,通过App也能跨应用完成复杂的多步骤任务。

腾讯科技向某安装了大模型App的普通手机提出了相关需求,其操作过程与内置大模型App的手机体验差别不大它可以完成如点附近最便宜的全家桶、给某个群里所有人的第一条朋友圈点赞、打开线上会议、加入会议并在会议完成后把纪要发给老板、总结某公司财报后形成分析报告并通过微信发送给老板等需求。

那么,如果此类大模型应用都能解决自主操作的问题,AI手机的优势在哪里?目前来看,AI手机时代,“数据”依然是最深的护城河手机拥有用户使用手机的本地化数据,具有天然的优势腾讯科技与多位从业者沟通,不考虑隐私协议,仅从理论层面来看,手机品牌厂商可以获得的用户数据包括:。

● 设备信息:型号、系统、硬件配置(CPU、内存、分辨率)和状态(电量、信号、网络)● 应用信息:名称、版本、开发者;安装和更新详情;使用情况(启动次数、时长、功能)● 用户行为:操作记录(点击、滑动、输入);浏览、搜索、下载历史;个人设置(主题、字体、语言)。

● 位置信息:当前和历史位置;位置服务使用(导航、地图、搜索)● 通信记录:通话、短信、邮件● 网络使用:连接详情(Wi-Fi、蓝牙);流量使用(上网时间、消耗)● 传感器和环境:传感器数据(加速度计、陀螺仪、摄像头);环境信息(温度、湿度、光线)。

● 账户信息:注册、登录信息;账户关联(邮箱、电话、社交账号)这意味着,对于一台手机来说,几乎所有的操作、细致到屏幕上任何一个文字和按钮,都可以被“原子化”写入到AI理解的范围内当这些原子化的数据成规模地出现在手机AI的学习范围内时,它就能够形成一个最初的用户个人知识库。

然而,仅以本地化的用户行为数据作为学习范围显然是不够的,智能手机的更多功能依赖于各种不同的第三方App,这些第三方的数据才能告诉AI智能体,用户最爱吃牛肉汉堡还是鸡肉汉堡、喜欢喝冰美式还是热美式因此,要真正实现意图识别,让手机成为每个人的AI智能体,终究绕不开从底层理解用户行为,这需要整个生态的配合。

但是,第三方应用数据的缺失,让手机厂商们无法通过API调用解决AI自主操作的问题,不得已选择屏幕识别这样的技术路线,绕过数据护城河手机厂商在用阻力最小的方式先做到让手机变得“更智能”,现阶段,它可以帮助用户操作手机且不需要App们同意,算是迈出了第一步。

腾讯科技咨询了一位手机行业资深产品经理,他表示:“当前AI手机绕过数据交换确实是不得已而为之的行为如果要解决‘简单调用’的问题,通过API是可行的,但在目前的手机生态中很难实现,因为没有App有足够的动力向手机厂商开放API。

而模拟点击则不需要,只要手机在系统级别支持就好,而手机操作系统有动力,因为大家都想让自己的操作系统变得更智能”理想的AI手机体验,是无形的服务理想的“AI手机”体验,应该是帮助用户于无形之中今年行业内用一个词来描述这种体验,叫做“意图识别”。

简单来说,就是手机、PC等端侧设备能够穿透用户意识的“迷雾”,做到比用户自己更懂自己的“意图”手机的Agent(智能体)接收个性化的意图指令,自动帮忙执行一系列任务手机厂商目前通过屏幕识别,“连续点按”App的操作,已经完成了类似于RPA(机器人流程自动化)的过程,但缺少“记忆”,即用户散落在各个第三方App中的第三方应用的行为偏好数据。

这并不能从根本上解决数据互通的问题,只是形式上的智能,不是根本的智能手机仍然无法判断用户在具体场景中的真正喜好数据的壁垒和生态的难题,真的完全无解吗?某资深从业者告诉腾讯科技:“目前行业内初步形成了一个有共识的解决方案,未来,可能每个手机App都会拥有一个独立的Agent,大家所做的就是让手机系统级别的Agent和应用的各个第三方Agent握手通信。

本地的Agent负责理解用户意图,将脱敏后的数据转递给第三方的Agent,对方完成后再返回给手机,以满足用户需求”这如同每个App派出一个Agent代表,接收其他App及系统的请求——“只反馈请求,不交出数据”,这看起来确实是一个不错的解决方案。

然而,雏形已成,但还有几个问题需要解决:1. Agent和Agent之间、手机操作系统和Agent之间,如果没有统一的通信协议和标准,如何真正实现“握手”交互和流转?2. 大模型采用明文传输,在Agent互相握手传递需求时,是否有切实有效的方式保护敏感的个人数据?

3. 一个系统级别的Agent,理应与手机操作系统深度融合,甚至是手机操作系统的一部分,现有的手机操作系统的底层架构是否能完美支持这样一个强大的Agent?从表面上看,AI助手让手机操作变得更加便捷;但深入来看,Agent间的通信协议、数据安全传输、系统架构重构等问题,都需要整个行业达成共识。

就像互联网需要HTTP协议一样,AI时代的手机生态同样需要建立新的“游戏规则”在这场无声的变革中,一个问题值得我们思考:让AI真正融入手机生态,我们是否准备好了?END阅读推荐

眼睛疲劳,手指酸痛,想要游戏更轻松?试试【星界云手机】吧!它以云端托管手游为基础,让你告别手指疲劳,只需坐享游戏乐趣。挂机脚本助你24小时不间断打怪升级,游戏更轻松,享受游戏乐趣!

本站所有文章、数据、图片均来自互联网,一切版权均归源网站或源作者所有。

如果侵犯了你的权益请来信告知我们删除。邮箱:631580315@qq.com