没想到_杨植森简介_杨植麟们云厂商的顶尖商务拓展

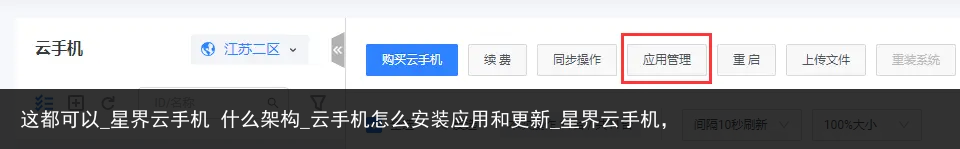

19世纪中后期,贪婪的欧洲列强对古老且原始的非洲垂涎欲滴,纷纷瓜分这片大陆120多年后,新兴的AI产业也开始步入类似的境况 故事始于一片繁荣景象,一方慷慨解囊提供资金和算力;另一方心怀感激,推出类似ChatGPT的新成果震撼世界。

然而,这些美好的承诺很快烟消云散,矛盾开始显现回头一看,许多AI企业发现自己已负债累累 目前,全球主要的云服务提供商已通过合作、投资等方式与AI企业紧密绑定国外,微软与OpenAI,亚马逊与Anthropic;国内,阿里独揽大权,提前锁定了智谱、月暗、零一万物、Minimax等“AI五小虎”。

OpenAI最新完成的66亿美元融资将成为一个转折点新一轮融资完成后,OpenAI详细公布了财务模型和利润规划,这意味着大模型即将实现盈利,“还债”不再是难题 在OpenAI周围,微软和VC们已蠢蠢欲动,亚马逊和谷歌也紧盯着自己的目标。

回到中国,策略直接而简单,参照OpenAI的做法,对AI“六小虎”(指智谱、月暗、零一万物、Minimax、阶跃星辰)设定盈利预期和时间表 或许意识到即将到来的压力,近期的AI企业纷纷采取收缩措施,“开源节流”成为当前的主要任务。

根据国内外AI企业的协议,在“一(云)对多(模型)”的代理模式下,模型企业实际上成为了云服务提供商的“打工者”除了支付高昂的算力账单,还要为云服务提供商的年终业绩贡献力量未来盈利后,还需按投资股份的比例分享利润。

大模型企业的焦虑情绪蔓延,竞争激烈,背后隐藏的庄家则渔翁得利阿里巴巴云、腾讯云等通过广泛投资AI企业,这次将轻松获利 **云,大模型的“信用卡”** 云计算,在大模型时代,堪称比黄金更重要的“硬通货”。

OpenAI与微软的百亿美元合作曾是AI界的佳话,但据媒体报道,截至去年9月,OpenAI仅收到“一小部分”资金其中“很大部分”用于购买云服务资源,而非现金形式支付 在中国,阿里也借鉴了微软的投资模式,并在此基础上加以灵活改造。

同样通过云服务为AI企业提供“信用卡”服务,预支使用云的“信用额度”例如,在投资月暗的8亿美元中,云服务的信用额度占了一半左右在此基础上,阿里的投资并未直接转给AI企业,而是存放在一个托管账户中,所划掉的云服务额度可重新计入其收入。

因此,云服务实际上扮演了双重角色初期,由于算力和大模型的依赖关系,云服务成为了打开大模型投资的关键后期,云服务成为了“提款机”,源源不断从AI企业获取利润 收益主要来自两部分一是云服务的消耗AI企业在模型训练到后期API调用过程中,都会产生费用,计入云服务提供商的AI业务收入中。

例如,微软与OpenAI的关系中,GPT模型训练和ChatGPT产品的运行均在微软云上进行,通过Azure向客户提供的ChatGPT相关服务也需要再次计费 即便是大模型上云所产生的收入,也有一大部分流入了云服务提供商的口袋。

国外的一项调查表明,当客户在亚马逊Bedrock调用Claude,或在微软Azure调用GPT时,每支付一美元推理费用,约有超过50%的收入支付给了云服务提供商,用于支付基础设施成本和毛利润分成 实际情况显示,阿里在这方面更有说服力。

毕竟国内超过一半的大模型企业都在使用阿里云财报显示,2024财年第三季度,阿里云营收280.66亿元,增长3%,经调整EBITA利润增长86%至23.64亿元可见,即使在短期内,AI企业的高消耗也为云服务提供商带来了正向拉动效应。

这种状况让云服务提供商笑得合不拢嘴,但对于AI企业来说却是一场噩梦虽然算力额度是必需的,但更像是“空头支票”,日常运营和各种成本支出仍需依赖账面上的流动资金难怪OpenAI在最近一轮融资前多次强调,“至少支付2.5亿美元现金”。

另一部分利润则来自参与AI企业的利润分配最新消息称,OpenAI未来的利润分配主要分为三层,前两层用于偿还给投资者和微软,只有分配完毕后,剩余部分才真正归OpenAI所有包括OpenAI在内的AI企业处境一目了然:欲求独立,先还清债务。

在国内,云服务提供商的话语权更大,尤其是阿里,通过大量投入云服务,终于迎来了“讨债”的时机与OpenAI相比,国内头部的大模型企业如“六小虎”的生存环境更加艰难,如何创造收入成为关键问题 在国外,已经分化出两条路径:向左走To C,代表是OpenAI;向右走To B,代表是Anthropic。

星界云手机,让你的移动办公更加高效便捷!24小时稳定在线,专业级GPU硬件加速,支持多种办公应用,让你随时随地完成工作任务,实现移动办公的无缝连接。

从云服务提供商手中夺食需要满足前提条件,即模型和产品能力要显著超越云巨头OpenAI对于微软,Anthropic对于亚马逊都是如此但在中国,这个前提条件基本不成立至今为止,双方尚未拉开明显差距,反倒是云巨头在流量、生态和客户市场方面更具优势。

AI企业在云服务提供商面前显得更加弱势,“绑定”程度因企业而异透支未来算力虽然最终可以还清,但云服务提供商不甘心止步于此有些企业还在云服务上增设了额外的门槛,如“定制芯片”、客户绑定、技术买断等还有许多中间地带,如云服务提供商对模型的访问权限、用户数据所有权等。

**大模型的“赏味期”** 目前,云生态的锁定价值大于单一模型本身,这一点在全球范围内都适用“云+大模型”本质上是在为云服务增值,使云服务变得更加丰厚而单一的大模型具有“赏味期”,一旦过了最佳使用期,其价值就会大幅下降。

从去年到现在,整个行业始终处于不断变化之中,大模型排行榜随时更新,“史上最强模型”称号以月为单位易主GPT系列模型从最初的3.5进化到现在的o1,其竞争对手Claude系列模型也一路追赶至3.5 Sonnet。

尽管这是正常的迭代路径,但从模型使用的角度看,新模型在最初几个月使用频率最高,随后会有更强性能的模型替代例如,在编程领域,后来居上的Claude模型击败了GPT-4,成为更多编程软件的选择随着时间推移,模型本身的价值在不断降低。

此前,行业内曾讨论过“大模型能否成为商品”这一话题,至今仍未找到确定的答案 通用大模型被集成的趋势正在增强,一部分被云服务提供商集成,一部分被应用产品集成,多模切换调用越来越普遍光子星球注意到,国内许多创业公司采用这种方法,提前测试各家模型的免费额度,在产品运行时及时切换以降低成本。

当然,还有一种情况是根据用户调用不同功能来切换模型 在没有哪家大模型能够独霸天下的情况下,云与大模型的融合可以加快产品化进程众所周知,GitHub虽然是顶级开源社区之一,但由于与微软的“Azure+GPT”生态绑定,被迫与“Azure+GPT”生态进行整合。

其中,GitHub Copilot直接采用了GPT模型尽管GitHub也推出了相关模型产品,允许支持OpenAI以外的模型,但仅限于与微软生态不直接竞争的模型,生态自带的排他性不言而喻 由云到大模型再到产品,云服务提供商的触角不断延伸。

大模型企业为云服务提供商的生态系统做“嫁衣”,即使处于“赏味期”也能无延迟地享受最强性能的大模型此外,绕过OpenAI们的收费墙,在生态系统应用中也能尝试部分功能 在国内,云服务提供商的“藩篱意识”更强,AI企业几乎难以触及他们的生态系统产品。

即便是以API形式输出,云服务提供商也非常吝啬这既有对竞品的顾虑,也有出于数据安全的考虑藩篱之内,云服务提供商通过自建模型完成了产品升级藩篱之外,才有可能出现站台、共同服务客户、投资等友好形式 云服务提供商的领地主义,间接为AI六小虎关闭了生态入口。

他们无法像OpenAI一样,在拥有规模化用户和成熟产品的情况下获得曝光和反馈因此,自建入口和主动试探藩篱边界成为了一种无奈之举 **新的价值** “云+大模型”的组合并非无懈可击MaaS提供的仍然是标准化服务,相当于提供了统一的锤子、钉子套装,具体怎么用取决于使用者的能力。

能力越强、经验越丰富的用户运行大模型的效果越好这也解释了为何阿里、百度等厂商要大力打造大模型行业的标杆 云服务、大模型到应用之间存在巨大的鸿沟面向B端的解决方案需要个性化定制,而面向C端的应用尚处于探索阶段。

近期红杉报告指出,在云和大模型之外,新的价值在于“将模型的原始能力转化为引人入胜、可靠的端到端商业解决方案”,这需要大量的工程化工作 不可否认,大模型淘汰了一些应用,持续升级的能力覆盖了许多创业公司的项目。

许多人强调“要站在OpenAI射程之外”大多数情况下,不是缺乏最强的模型,而是未能充分释放模型的最大效能 AI编程应用Cursor的成功在某种程度上证明了开发模型能力的重要性正如前所述,Cursor的思路不是提供工具,而是代替用户去试错。

基于对代码编辑、处理速度、处理数量、长上下文等能力的要求,Cursor在测试了市面上最前沿的模型后,选择了最适合的Claude Sonnet Cursor在采访中强调了一点,这或许是当下过度追求模型性能的群体所忽视的问题:“最好的不一定是最适合的”。

在Sonnet之后,他们也第一时间测试了OpenAI的o1模型,得出的结论是:“推理能力很强,在某些问题上可以做得很好,但仍不及Sonnet” 这从侧面回答了一个问题:当拥有了最厉害的模型后,为什么还没有诞生杀手级应用?面对大模型,以前创业公司的课题是做选择,而现在变成了做优化组合。

或许,直到现在,大模型行业才真正进入了“应用诞生时刻”

星界云手机,为你提供无限扩展的云端移动能力!群控改机、定制镜像、界面预览、应用安装、云机授权、灵活组网,多种功能助你灵活应对各种场景需求。

本站所有文章、数据、图片均来自互联网,一切版权均归源网站或源作者所有。

如果侵犯了你的权益请来信告知我们删除。邮箱:631580315@qq.com